AIGC 跟 Web3 有什么关系?有哪几个方向值得关注?

撰文:李科

AIGC 听起来这么好,那跟 Web3 会有什么关系?大概有这几个方向值得关注。

由 AI 作画应用 Midjourney 生成的绘画作品《太空歌剧院》在今年 9 月美国科罗纳州博览会上获得艺术比赛一等奖,吸引了不少人的眼球。今年以来连续好几个 AIGC 领域的项目获得了不错的融资, 到底 AIGC 有什么特别之处?本文中,PANews 将对 AIGC 近来的发展作一个梳理介绍。

美国科罗纳州博览会获奖艺术作品《太空歌剧院》

什么是 AIGC?

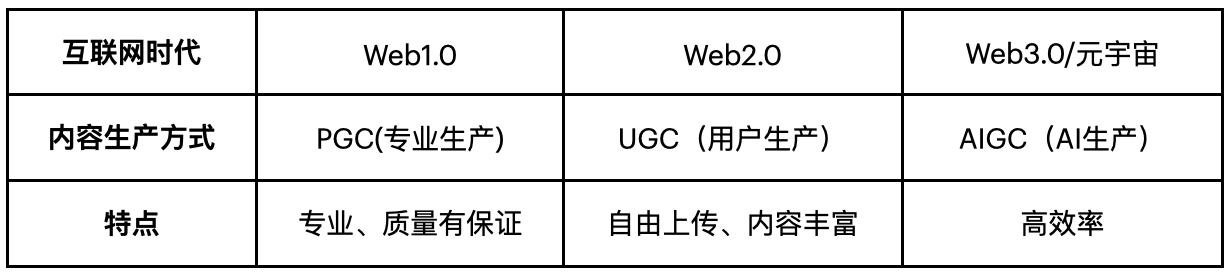

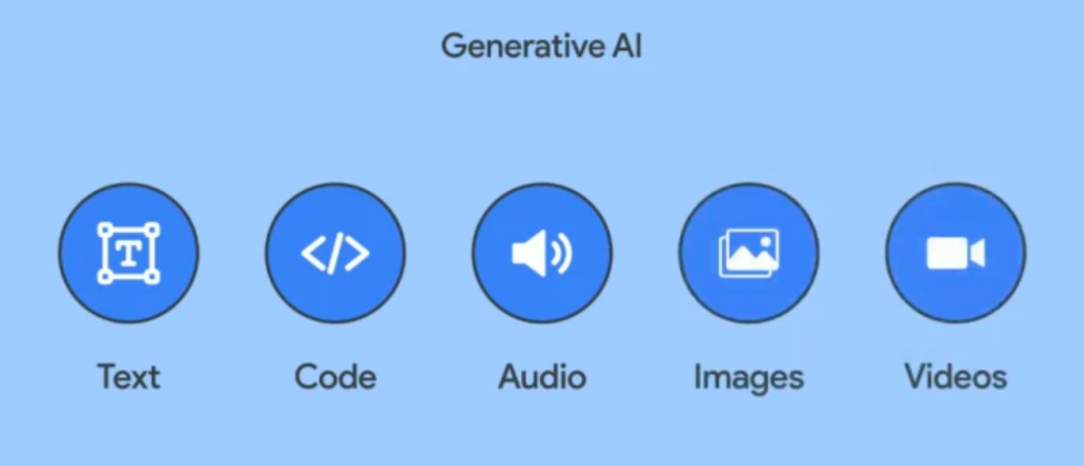

互联网内容生产方式经历了 PGC——UGC——AIGC 的过程。PGC(Professionally Generated Content)是专业生产内容,如 Web1.0 和广电行业中专业人员生产的文字和视频,其特点是专业、内容质量有保证。UGC(User Generated Content)是用户生产内容,伴随 Web2.0 概念而产生,特点是用户可以自由上传内容,内容丰富。AIGC(AI Generated Content)是由 AI 生成的内容,其特点是自动化生产、高效。随着自然语言生成技术 NLG 和 AI 模型的成熟,AIGC 逐渐受到大家的关注,目前已经可以自动生成文字、图片、音频、视频,甚至 3D 模型和代码。AIGC 将极大的推动元宇宙的发展,元宇宙中大量的数字原生内容,需要由 AI 来帮助完成创作。

内容生产方式演变过程

AIGC 底层技术突破

底层技术的突破使 AIGC 商业落地成为可能,传统 AI 绘画技术采用生成对抗网络(GAN),但 GAN 生成的图片结果输出不稳定,分辨率低。直到 2021 年 OpenaAI 团队开源了其深度学习模型 CLIP,以及今年 7 月出现的去躁扩散模型 Diffusion,两者相互结合,让 AI 自动生成文字和图片的质量得到了质的提升。

Diffusion 是一种去噪扩散模型,工作原理是对图像逐步施加噪点,直至图像被破坏变成完全的噪点,然后再逆向学习从全噪点还原为原始图像的过程,而 AI 所看到的是全是噪点的画面如何一点点变清晰直到变成一幅画,通过这个逆向过程来学习如何作画。

CLIP 是 OpenAI 在 2021 年初发布的用于匹配文本和图像的神经网络模型,是近年来在多模态研究领域的杰出成果,它一方面对文字进行语言分析,另一方面对图形进行视觉分析,不断调整两个模型内部参数,达到文字和图像高度匹配的效果。

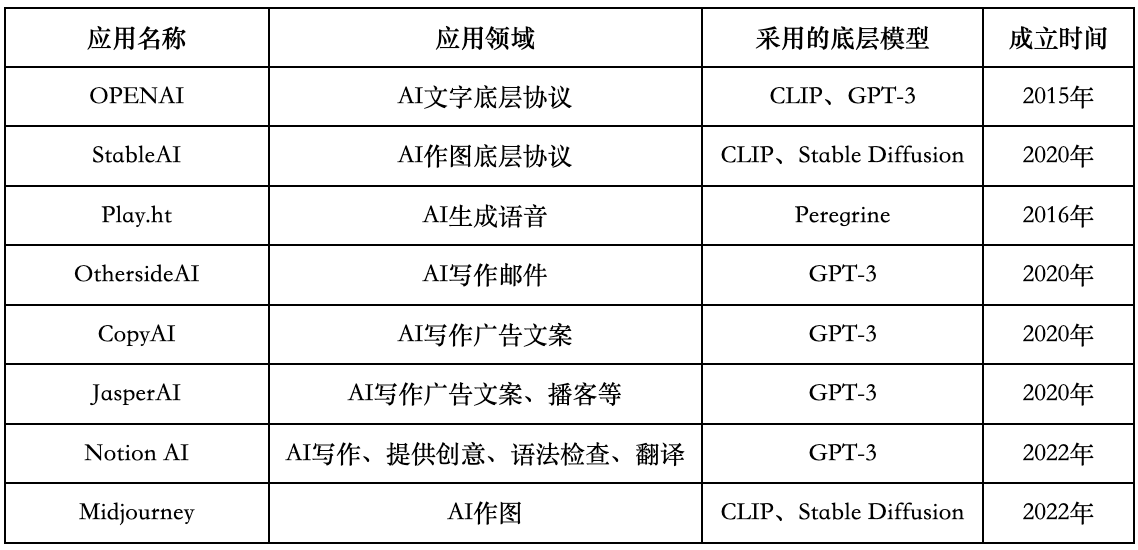

在 AI 生成文字方面,目前 AI 已经可以作诗、写邮件、写广告、剧本和小说。在今年,采用 AIGC 技术的虚拟人度晓晓写作高考作文,在不到 1 分钟的时间,完成了 40 多篇文章,获得专家打分 48 分的成绩,击败了 75% 的考生。目前 OpenAI 的 GPT-3 模型是 AI 生成文字中最成熟的模型,最近有一些项目把 GPT-3 模型商业化,包括自动写邮件的 OthersideAI,自动写广告文案的 Copy.ai 和 Jasper.ai,在用户数量上突飞猛进,并获得了大笔的融资,就在 11 月 16 日知识管理和内容协作平台 Notion 也发布了其文字自动生成产品 Notion AI,并开始 Alpha 版本测试,Notion AI 也是基于 GPT-3 模型开发。

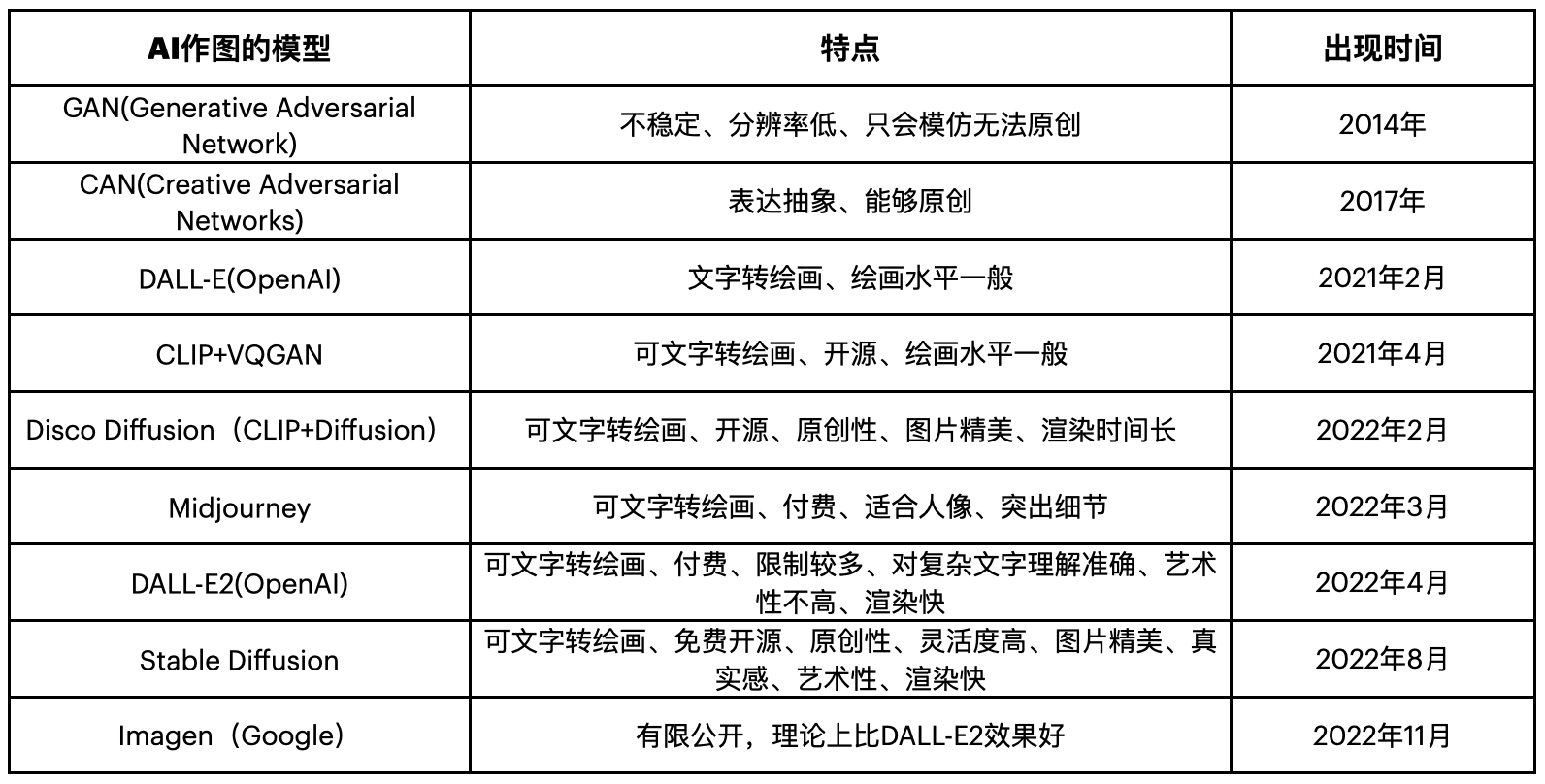

在 AI 生成图片方面,今年 AI 作画水平突飞猛进,其背后的算法模型也在不断迭代,年初推出的 Disco Diffusion 只能生成粗糙的图片,4 月 OpenAI 发布的 DALL-E2 代已经可以生成完整的人像和图片,到 8 月 StabilityAI 发布的 Stable Diffusion 模型取得质的突破,已经可以生成可以媲美专业画师的作品,生成图片的效率也从年初的数小时到现在的几分钟甚至数十秒。

AI 生成图片技术演变

在 AI 生成音频方面,10 月 11 日,AI 播客 Podcast.ai 生成的一段关于乔布斯和美国知名主持人乔·罗根之间的 20 分钟访谈播客在科技圈广为流传,在播客中乔布斯谈到自己的大学时代、对计算机、工作状态和信仰的看法,整个播客听起来毫无违和感,基本做到以假乱真。

由 AI 生成的乔·罗根采访乔布斯播客

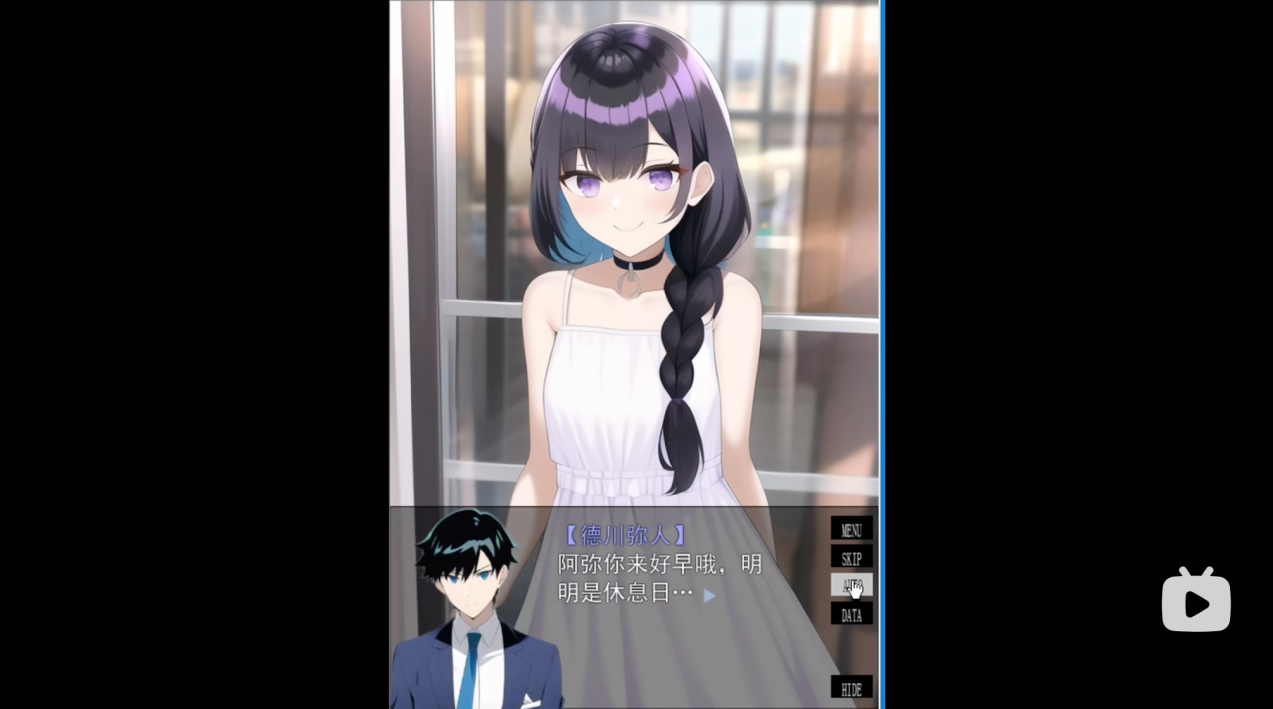

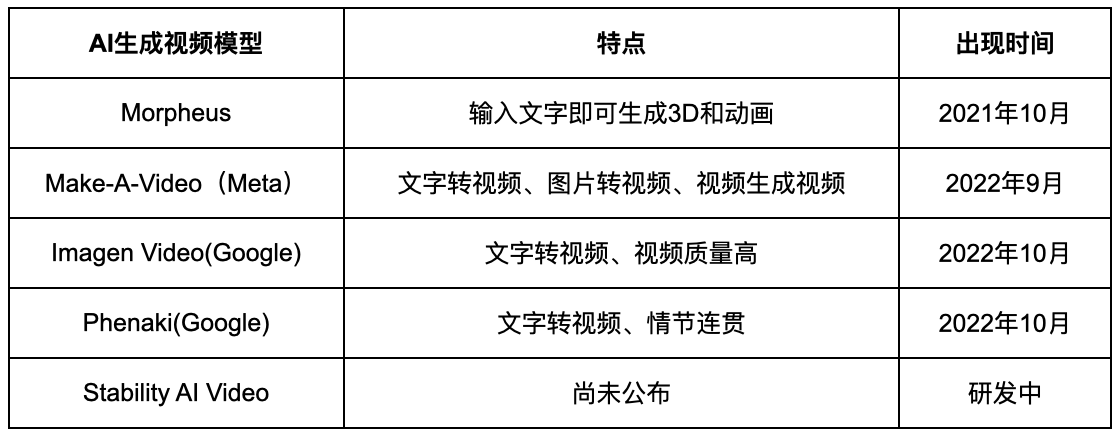

在 AI 生成视频方面,目前 AI 生成视频的算法模型还未成熟,也还没出现一家独大的局面。9 月底 Meta 公布了 AI 制作视频工具 Make-A-Video,Google 也紧接着发布了 Imagen Video 和 Phenaki。Make-A-Video 具有文字转视频、图片转视频、视频生成视频三种功能。仅仅通过文本描述,Phenaki 就可以生成一段情节连贯的视频。10 月 9 日 B 站上的 UP 主「秋之雪华」公布了全球首个 AI 绘图、AI 配音的动画《夏末弥梦》的 DEMO,其画面精美程度不输专业画师的作品。

AI 动画《夏末弥梦》DEMO

但 PANews 观看该 DEMO 后发现,动画中人物几乎是静态的,只是在场景切换时换了个另一张图,由此可以看出目前 AI 生成视频中动画的过度和连贯性技术还不是很成熟,因为 AI 生成视频需要多个 AI 模型来配合完成。

AI 生成视频技术模型

从技术上看,视频是把多张图片有逻辑和连贯的组合在一起。由文字生成视频,首先要生成多张图片,然后还要把这些图片有逻辑和连贯性的组合起来,因此难度比文字生成图片高了很多,如果一旦像文字生成图片那样能够高效率的生成高品质视频,将对内短视频、影视、游戏、广告等内容生产行业带来重大影响,不仅提升视频制作的效率和成本,还能帮助设计师产生更多的灵感和创意,让视频内容行业变得更加丰富和繁荣。

在 AI 生成 3D 方面,以往的「3D 建模」需要利用三维制作软件通过虚拟三维空间构建出具有三维数据的模型,技术要求比较高,需要懂美术、熟悉 3DMAX 和 Maya 等软件,还需要大量的时间去人工绘制。但 UC Berkeley 的几个博士后发表的论文神经辐射场技术(NeRF)可以把全景相机拍摄的视频自动渲染为 3D 场景,减少了人工 3D 建模的过程,NeRF 技术在 2020 年的 ECCV ( 欧洲计算机视觉国际会议 ) 提出, 并在 2021 年的 ACM(美国计算机协会)获了荣誉提名奖。著名 VR 科技博主 Robert Scoble 7 月在他的 Twitter 发布了这个视频,他用 NeRF 技术渲染 Insta360 全景相机所拍视频后得到的 3D 场景,效果令人惊叹,预计会有相关项目将 NeRF 技术进行商业落地尝试,对于这点非常值得期待。

AIGC 领域重要项目

今年加入 AI 作画赛道的公司越来越多,今年分别出现了 Mid Journey、DALL-E2、Stable Diffusion、Tiamat、百度文心等多家 AI 作画公司,以及 JasperAI、CopyAI 这样的 AI 文字项目。

从融资角度来看,目前 AIGC 有 3 个商业化的方向:

- 第一个方向是通过 AI 生成文字,比如自动写邮件和广告营销文案,这要归功于 OpenAI 的 GPT-3 AI 语言模型,目前大多数 AI 生成文字类项目都使用该模型。

- 第二个方向是利用 AI 作图,主要技术是结合多模态神经语言模型 CLIP 和图像去躁扩散模型 Diffusion,仅仅提供一些关键词描述就可以自动生成图片。

- 第三个方向是 AIGC 的底层技术模型开发,OPENAI 和 StableAI 是这个方向的龙头,也是融资金额最大的。

预计接下来 AIGC 的热门方向可能是用 AI 生成视频和动画,这就看 Meta、Google 的 AI 视频模型能不能解决视频的连贯性和逻辑性问题,或其他公司提出更好的解决方案。

AIGC 领域热门项目

OpenAI/GPT-3, OpenAI 是由马斯克和 Y-Combinator CEO Sam Altman 于 2015 年成立的一个非营利组织,但 2019 年马斯克离开了 OpenAI ,紧接着微软注资 10 亿美元将其变为营利性公司,并与微软的云计算平台 Azure 展开合作。最近微软正在对 OpenAI 进行新一轮的投资进行后期谈判,目前估值已经达 200 亿美金。GPT-3 是 OpenAI 于 2020 年 5 月推出的自然语言处理模型,支持用户仅输入一些关键词就能生成一封邮件、文章或新闻,甚至是小说,它是目前最成熟的自然语言生成技术 NLG 之一。今年 4 月 OpenAI 还推出了 DALL-E2 项目,允许用户通过文本生成图像,成为目前主流的三大 AI 作画应用之一。

StableAI /Stable Diffusion,10 月 17 日英国的 Stability AI 宣布以 10 亿美元的估值完成 1.01 亿美元融资,此次融资由 Coatue 和 Lightspeed 领投。消息称 Stability AI 正准备下一轮 10 亿美金的融资,本轮融资 Google 可能会参与,如果投资成功,相信 Google 将会和 StableAI 深度合作。Stability AI 成立于 2020 年,由去中心化组织 EleutherAI 支持开发,其理念是「AI by the people, for the people」。StableAI 主要研 AI 生成图片、音频、视频和 3D 的模型,其研发的开源 AI 作图模型 Stable Diffusion 在 2022 年 8 月一经推出就立刻吸引了大家的眼球,在 Stable Diffusion 的 Dream Studio 测试版网站中只要输入文字描述,它就能生成一副可以媲美专业画师的图片,Stable Diffusion 是开源产品,一些 AIGC 项目对其进行了二次开发,退出了包括图像、语言、音频、视频、3D、生物 AI 等模型。

由 stable diffusion 生成的图片

Midjourney:Midjourney 是一款可以和 Stable Diffusio 以及 DALL-E2 媲美的 AI 绘画工具。Midjourney 是部署在 Discord 上的应用,在 Discord 里输入文字,一分钟就可以生成对应的图片,目前其官方 Discord 已经拥有 140 万用户,其免费版本能生成的图片数量有限,超出数量需要付费订阅,如果想体验一下 Midjourney 作图可以查看这个教程。

由 Midjourney 生成的图片

OthersideAI:OthersideAI 主打利用 AI 自动回复邮件,底层技术采用 OpenAI 的 GPT-3 协议,OthersideAI 曾获得 Madrona Venture Group 领投的 260 万美金种子轮融资,Madrona Venture Group 曾参投过 Amazon 的早期种子轮融资。 OthersideAI 的操作非常简单,只要输入邮件内容的关键要点,它就可以为生成一封完整的邮件。

CopyAI:Copy.ai 是一个通过 AI 来写作广告和营销文案的创业公司,它可以帮助用户几秒钟内生成高质量的广告和营销文案,主打 ToB 商业场景,它的底层技术也是采用 OpenAI 的 GPT-3 协议。目前 Copy.ai 的用户包括像微软、Ebay 这样的大公司。Copy.ai 曾获得 Craft Ventures 领投的 290 万美金种子轮,A 轮融资 1100 万美金,由 Wing Venture Capital 领投,红杉资金及 Tiger Global 跟投。

JasperAI:Jasper.ai 成立于 2020 年,通过 AI 帮企业和个人写营销推广文案以及博客等各种文字内容(和 Copy.ai 类似),其底层技术也是 GPT-3。Jasper.ai 10 月以 15 亿美金估值完成了 1.25 亿美元的 A 轮融资,由 Insight Partners 领投,Coatue、BVP 以及 IVP 跟投。今年 1 月推出第一个版本后,很快受到欢迎,短时间内获得了数百万美元的收入。

Play.ht:Play.ht 是一个 AI 文本转换语音应用,在今年 9 月发布了第一个语音模型 Peregrine,包含数千种说话的声音,可以学习人类的语气、音调和笑声。再进生成采访乔布斯播客的 Podcast.ai 就是采用 Play.ht 语音模型,它通过大量采集网络上关于乔布斯的录音,然后进行训练,最终生成假乔布斯的声音,相似度非常高。

Notion AI:刚刚于本月 16 日公布的 Notion AI 是知名知识管理和内容协作平台 Notion 基于 OpenAI GPT-3 模型开发的 AI 文字生成工具。目前 Notion AI 的功能包括自动撰写文章、广告文案和播客;通过头脑风暴为用户提供创意建议;自动检查文字拼写和语法错误;自动翻译文章;目前 Notion AI 以白名单的形式开放 Alpha 版本测试。相信 Notion AI 的加入将会进一步推动 AI 生成文字走向普及。

AIGC 如何助推元宇宙发展

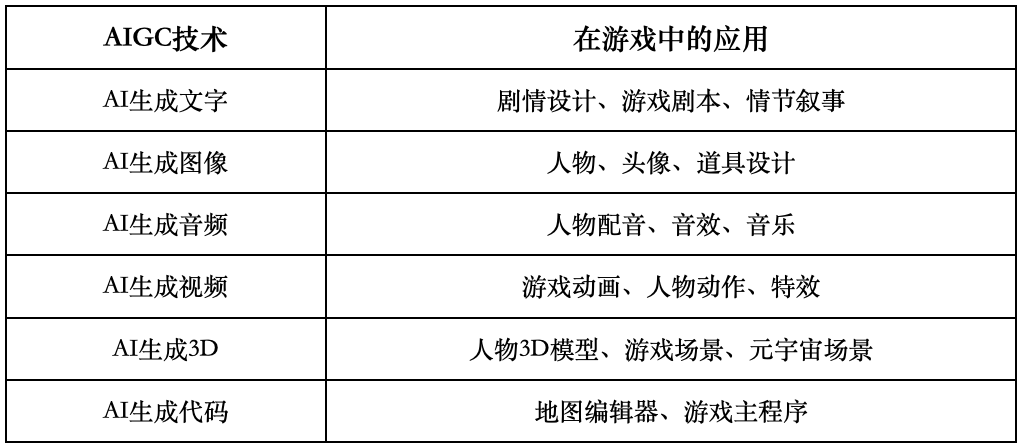

虽然元宇宙的终极形态还无法确定,但可以肯定的是元宇宙将极大扩展人类的存在空间,在我们迈向元宇宙的过程中,需要大量的数字内容来支撑,单靠人工来设计和开发根本无法满足需求,AIGC 正好可以解决这个问题。游戏将是元宇宙中最先落地的场景,元宇宙和游戏有一个共同点,都是为用户提供高度的真实感和沉浸式体验,我们可以拿 AIGC 在游戏中的应用来说明其将如何主推元宇宙发展。

AIGC 技术在游戏中的应用

开发游戏周期长和成本高,通常需要花费几年时间和上千万资金,好在 AIGC 可以极大提高游戏的开发效率,具体来说,游戏中的剧本、人物、头像、道具、场景、配音、动作、特效、主程序未来都可以通过 AIGC 生成。根据 AIGC 在文字和图像方向的推进速度,以上应用在五到十年之内应该可以实现。

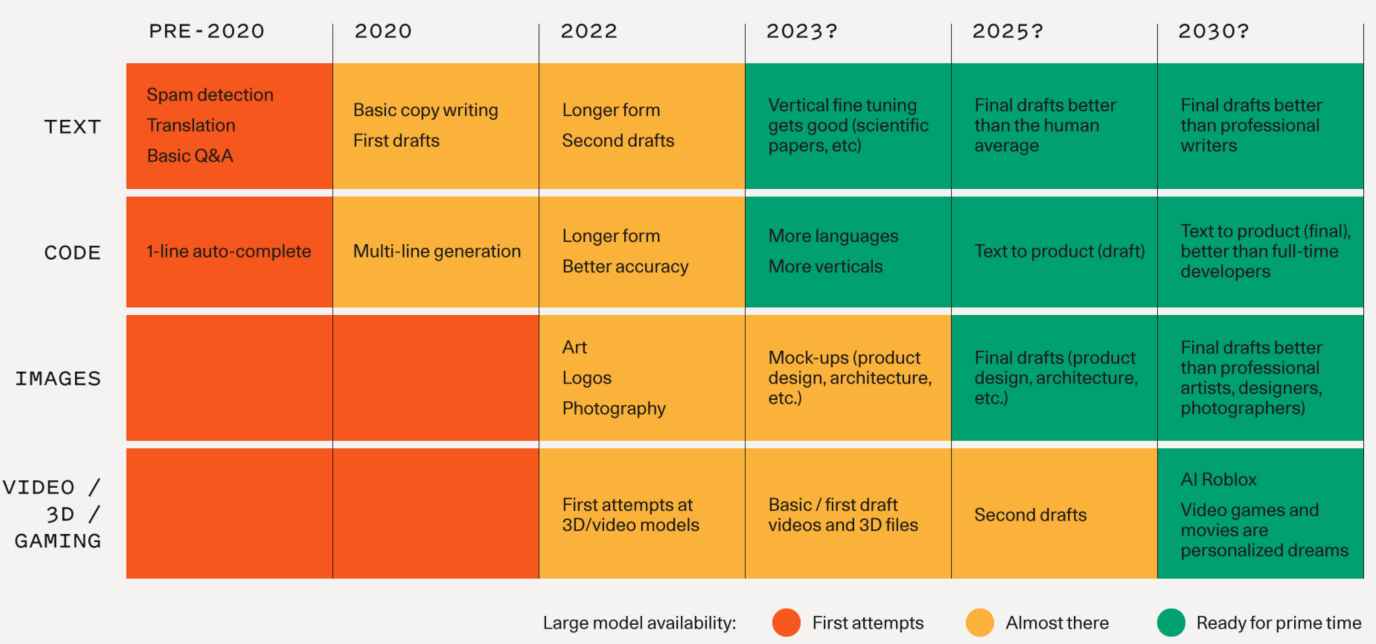

红杉资本在最近的研究报告中也指出,到 2030 年文本、代码、图像、视频、3D、游戏都可以通过 AIGC 生成,并且达到专业开发人员和设计师的水平。

图片来源:红杉资本

除了游戏之外,虚拟人也是元宇宙的一个重要落地场景,AIGC 同样也会促进虚拟人赛道的发展。

虚拟人是围绕一个虚拟的人设,为其设计声音、形象、动作、性格以及活动场景,其本质和游戏相似度很高。虚拟人注重一个人在虚拟世界的表演和功能性,游戏注重多个人在虚拟世界中的交互体验。游戏是一出戏,虚拟人也是在演一出戏,戈夫曼拟剧理论中的「人生如戏」一语道破了现实世界、虚拟世界的本质。

AIGC 在 Web3 方向的应用

AIGC 听起来这么好,那跟 Web3 会有什么关系?最近听说 Web3 的基金都在看 AIGC 方向的项目,我想大概有这几个方向值得关注。

Gamefi 开发引擎:在传统游戏中应用最广的开发引擎是 Unity 和 Unreal,但在 Web3 中,游戏的开发范式也许会因 AIGC 带来许多变革,因此将需要一个采用 AIGC 技术的 Gamefi 开发引擎。里面的人物、场景、动画均用 AIGC 设计,游戏中的主程序和区块链部分也可以通过 AIGC 代码生成功能完成,如果这些都能实现,设计 Gamefi 游戏或者元宇宙场景将变得非常高效,这一套开发引擎将会具有极高的价值。目前看到 RCT AI 是运用人工智能为游戏行业提供完整解决方式的一个项目,但其在多大程度上采用了 AIGC 技术,还不得而知,不过已经有一款 Gamefi 游戏 Mirror World 是基于 RCT AI 来开发的,有兴趣的朋友可以进一步了解。

开发 Gamefi 游戏:退而求其次,如果一套 AIGC 全集成的 Gamefi 开发引擎还太遥远,那采用各个厂商提供的 AIGC 工具来开发 Gamefi 游戏也会极大的提高效率,比如用 AIGC 来生成游戏剧本、设计人物、生成动画这些都几乎都会很快实现,特别在 AI 生成视频和 3D 场景技术一旦成熟之后 Gamefi 游戏开发效率将会突飞猛进。

算力和数据共享:训练 AIGC 模型需要海量的数据和强大的算力,这导致成本非常巨大,AIGC 行业龙头 Stability AI 为了训练其 Stable Diffusion 模型,在 AWS 中运行了包含 4000 多个 Nvidia A100 GPU 的集群,运营成本高达数千万美元 。如果能通过去中心化方式发行 Token 激励用户提供训练模型所需的数据,就可以很好的解决 AIGC 生成中的版权问题。另外也可以通过发行 Token 的方式,激励用户提供训练模型所需要的大量算力,分散算力成本,实现成本共担,利益共享。

结语

今年 7 月李彦宏在百度世界大会上判断,AIGC 将分为三个发展阶段:「助手阶段」——「协作阶段」——「原创阶段」。「未来十年,AIGC 将颠覆现有内容生产模式。可以实现以十分之一的成本,以百倍千倍的生产速度,去生成 AI 原创内容。」

在最近的研究报告中,红杉资本的两位合伙人也认为:「AIGC 目前已经拥有更好的模型,更多的数据,更好的算力,预计杀手级应用该要出现了。」

对于以上判断,我们倾向于认同,AIGC 的出现意味着创作者将从繁冗的基础性工作中解脱出来,把更多的精力放到创意表达上,这是未来内容创作行业,甚至是人类工作方式的整体趋势。

【免责声明】市场有风险,投资需谨慎。本文不构成投资建议,用户应考虑本文中的任何意见、观点或结论是否符合其特定状况。据此投资,责任自负。